Nếu bạn đang quen thuộc với SEO, thì robots.txt không còn là một khái niệm xa lạ với bạn nữa. Tuy nhiên, nếu bạn mới bắt đầu với SEO thì có thể bạn chưa biết rõ về tệp Robots.txt là gì và vai trò của nó trong việc tối ưu hóa SEO cho website của bạn. Trong bài viết này, chúng ta sẽ cùng tìm hiểu về tệp Robots.txt, công dụng của nó, cách tạo và kiểm tra tính hợp lệ của nó.

Robots.txt là gì?

Robots.txt là một tệp tin đặc biệt được đặt trên root domain của website. Nó được sử dụng để chỉ định các khu vực (thư mục hoặc trang) mà robot của các công cụ tìm kiếm như Googlebot, Bingbot, Yandexbot, … được phép hoặc không được phép truy cập.

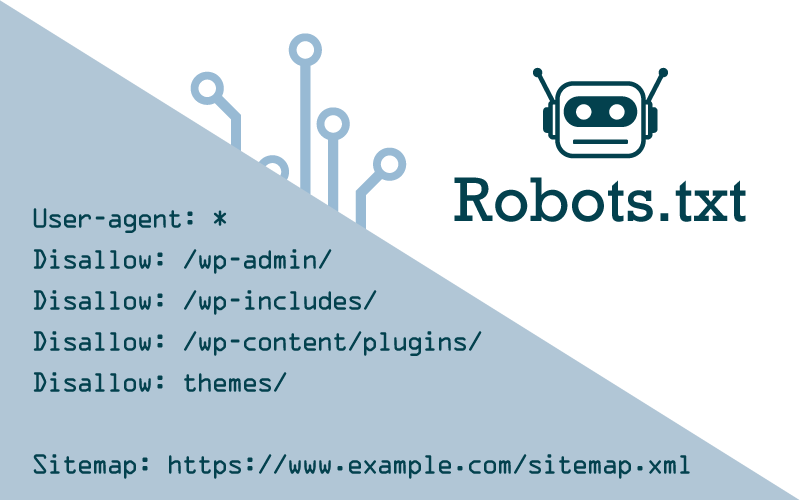

Cấu trúc của tệp Robots.txt

Tệp Robots.txt bao gồm hai phần chính: User-agent và Disallow. User-agent định nghĩa trình duyệt tìm kiếm nào được áp dụng lệnh sau đây, trong khi Disallow cho phép bạn chỉ định các phần của trang web mà không được phép robot tìm kiếm truy cập.

Ví dụ:

User-agent: *

Disallow: /private-folder/Trong ví dụ này, User-agent: * áp dụng cho tất cả các trình duyệt tìm kiếm. Và Disallow: /private-folder/ chỉ định rằng thư mục “private-folder” sẽ không được truy cập bởi robot của các công cụ tìm kiếm.

Bạn có cần tệp Robots.txt không?

Câu trả lời là tùy thuộc vào nhu cầu và mục đích của bạn. Nhưng về cơ bản, tệp Robots.txt là một công cụ hữu ích giúp bạn kiểm soát việc truy cập website của bạn bởi các công cụ tìm kiếm. Tuy nhiên, điều quan trọng cần lưu ý là tệp Robots.txt không phải là một cách để bảo mật website của bạn và không được sử dụng để ẩn các trang web hoặc thông tin khác tránh khỏi robot của các công cụ tìm kiếm.

Công dụng của robots.txt

1. Chặn công cụ tìm kiếm khi website chưa hoàn thiện

Khi bạn đang xây dựng một website mới hoặc đang tiến hành thực hiện bảo trì, bạn có thể sử dụng robots.txt để ngăn các công cụ tìm kiếm truy cập vào website của bạn. Điều này giúp bạn tránh được việc hiển thị những nội dung chưa hoàn thiện lên kết quả tìm kiếm.

2. Chặn trang tìm kiếm với các kết quả xấu

Nếu trong quá trình phát triển website, bạn gặp phải các trang web bị lỗi hoặc không đủ thông tin, bạn có thể sử dụng tệp Robots.txt để chặn các trang web này khỏi việc xuất hiện trên kết quả tìm kiếm.

3. Chặn các công cụ thu thập liên kết website

Nếu bạn không muốn một số công cụ thu thập liên kết website truy cập vào và tìm kiếm các liên kết trên website của bạn, bạn có thể sử dụng tệp Robots.txt để chặn các công cụ này truy cập vào các trang web của bạn.

Hạn chế của tệp robots.txt

Mặc dù tệp Robots.txt là một công cụ hữu ích cho việc kiểm soát robot của các công cụ tìm kiếm, nhưng nó vẫn có một số hạn chế:

1. Không phải tất cả các trình duyệt tìm kiếm đều hỗ trợ các lệnh trong tệp robots.txt

Các công cụ tìm kiếm khác nhau có thể có cách tiếp cận khác nhau với tệp Robots.txt. Do đó, một số trình duyệt tìm kiếm có thể không hiểu được các lệnh trong tệp Robots.txt và vẫn truy cập vào các trang web của bạn mà không bị giới hạn.

2. Mỗi trình dữ liệu có cú pháp phân tích dữ liệu riêng

Mỗi công cụ tìm kiếm có cách phân tích cú pháp của tệp Robots.txt riêng. Do đó, nếu bạn muốn viết một tệp Robots.txt hoạt động trên nhiều nền tảng khác nhau, bạn cần phải biết cú pháp của từng trình duyệt tìm kiếm.

3. Google vẫn có thể index các trang bị tệp robots.txt chặn

Mặc dù tệp Robots.txt có thể giúp bạn giới hạn việc truy cập vào trang web của bạn, nhưng không phải lúc nào Googlebot cũng tuân thủ các chỉ thị trong tệp Robots.txt. Điều này có nghĩa là một số trang web có thể vẫn được Googlebot truy cập và index dù đã bị chặn trong tệp Robots.txt.

Robots.txt hoạt động như thế nào?

Khi robot của một công cụ tìm kiếm truy cập vào website của bạn, nó sẽ đọc tệp Robots.txt và xem rằng nó có thể truy cập vào các trang web của bạn hay không. Nếu tệp Robots.txt cho phép truy cập, robot sẽ tiếp tục tìm kiếm các trang web của bạn. Nếu tệp Robots.txt không cho phép truy cập, robot sẽ không truy cập các trang web được chỉ định.

Cách tạo file robots.txt

Để tạo tệp Robots.txt cho website của bạn, bạn có thể sử dụng trình soạn thảo văn bản đơn giản như Notepad hoặc Sublime Text. Bạn cần đặt tệp Robots.txt trong thư mục gốc của website của bạn.

Ví dụ:

User-agent: *

Disallow: /private-folder/Trong ví dụ này, User-agent: * áp dụng cho tất cả các trình duyệt tìm kiếm. Và Disallow: /private-folder/ chỉ định rằng thư mục “private-folder” sẽ không được truy cập bởi robot của các công cụ tìm kiếm.

Cách kiểm tra và xác nhận hợp lệ cho robots.txt?

Để kiểm tra tính hợp lệ của tệp Robots.txt, bạn có thể sử dụng công cụ kiểm tra tệp Robots.txt miễn phí trên Google Webmaster Tools hoặc Bing Webmaster Tools. Nếu tệp Robots.txt của bạn không hợp lệ, công cụ sẽ báo l ỗi và chỉ ra những vấn đề mà bạn cần phải sửa đổi để tệp Robots.txt của bạn có thể hoạt động chính xác.

Ngoài ra, bạn có thể sử dụng công cụ Google Search Console để kiểm tra tệp Robots.txt của bạn. Nếu tệp Robots.txt của bạn bị lỗi, Google sẽ thông báo cho bạn biết lỗi đó là gì và cách khắc phục.

Robots.txt với WordPress?

Với WordPress, bạn có thể tạo tệp Robots.txt thông qua trình quản lý file của WordPress hoặc tạo một plugin tạo tệp Robots.txt. Nếu bạn muốn tạo tệp Robots.txt từ trang quản lý file của WordPress, bạn cần truy cập vào Thư mục Gốc, sau đó tạo một tệp tin mới và đặt tên là Robots.txt.

Nếu bạn muốn sử dụng plugin để tạo tệp Robots.txt, có nhiều plugin khác nhau để bạn có thể sử dụng. Một số plugin tạo tệp Robots.txt phổ biến nhất là Yoast SEO và All in One SEO Pack.

Robots.txt thực tế tốt nhất cho SEO

Để tối ưu hóa tệp Robots.txt cho SEO, bạn cần chú ý đến một số điểm sau:

- Sử dụng chỉ thị “Disallow” để chặn robot truy cập các trang web không mong muốn

- Không sử dụng chỉ thị “Disallow” để chặn các trang quan trọng trên website của bạn

- Sử dụng chỉ thị “Allow” để cho phép robot truy cập vào các trang web quan trọng

- Đảm bảo rằng tệp Robots.txt của bạn không chặn robot của Google truy cập vào các trang web quan trọng

- Thường xuyên kiểm tra và cập nhật tệp Robots.txt của bạn để đảm bảo hoạt động chính xác

Lời kết

Việc sử dụng tệp Robots.txt là một công cụ hữu ích trong việc kiểm soát robot của các công cụ tìm kiếm truy cập vào website của bạn. Tuy nhiên, bạn cần hiểu rõ về cấu trúc và cách sử dụng của tệp Robots.txt để đảm bảo tệp này có thể hoạt động chính xác và giúp tối ưu hoá SEO cho website của bạn.

Nếu bạn còn bất kỳ thắc mắc nào liên quan đến tệp Robots.txt và tối ưu hoá SEO cho website của bạn, hãy để lại câu hỏi của bạn ở phần bình luận bên dưới. Chúng tôi sẽ cố gắng trả lời câu hỏi của bạn trong thời gian sớm nhất có thể.